シスコとNEC による、AIセキュリティ戦略と新たな取り組み【3】

SpecialReport 有料期間限定無料公開中

Agentic AI時代における、SafetyとSecurityの課題

米Cisco

AIソフトウェア&プラットフォーム担当ヴァイスプレジデント

DJ Sampath氏

Agentic AI時代の新しい種類のリスク、深刻なリスクに対応するためにAIガバナンス(SafetyとSecurity)分野で協業した、CiscoとNEC。ここでは、Agentic AI時代のリスクと対策を技術的な面から見ていきたい。

記者説明会で登壇したDJ Sampath(サンパス)氏は、米CiscoのAIソフトウェア&プラットフォーム担当ヴァイスプレジデントを務めるキーパソンだ。本記事では、同氏による最先端の取り組みの解説を基に、SafetyとSecurityの課題や、Cisco AI Defenseの特長について、当編集部が周辺情報を補足しつつ纏めた。

Sampath氏の解説のポイントは次の通り。

・AIアプリケーションは他のアプリケーションと異なり、「モデル」という層がある。

・この「モデル」は複数の種類が存在し、攻撃手法も様々な性質のものが存在するので、適したセキュリティ手法はそれぞれの「モデル」ごとに異なる。「モデル」の種類は今後も増えていくので、様々な「モデル」を横断するセキュリティ手法が重要となる。

・Cisco AI Defenseであれば、様々な「モデル」を横断する包括的なセキュリティを実現し、“大規模な検証”や“大規模な保護”という革新的なイノベーションを顧客に提供できる。

ここからは、その詳細を見ていきたい。

Sampath氏はAgentic AI時代について、「AIが人間と同じような形でタスクを処理できるAGI(Artificial General Intelligence:汎用型AI)は、私が好きな定義だ。これは、スーパーインテリジェンスが手に届くところまで来ていることでもある。このスーパーインテリジェンスとは何かというと、あるタスクをAIが処理した際に、人間よりも優れた処理ができる場合があるということだ。人間が考えられなかったような結果を出す、これが実現可能なところまできている」と強調する。

現在の人間中心のワークフォースに、スーパーインテリジェンスなAIエージェントによるアプリケーション、ロボット、ヒューマノイドを活用することで、生産性を向上させることができる。これを今後、様々な企業が活用し、様々な社会インフラに広がっていくことになる。

Sampath氏は「AIエージェントは、従来(人間が100%のワークフォース)の生産性を10倍のキャパシティにしていく。だが、これにより、新しい種類のリスクが、今までにない規模で登場する」と警鐘を鳴らし、AIガバナンスの重要性について触れた。

AIアプリケーションには、複数の「モデル」という特異性がある。

Sampath氏は、AIガバナンス領域におけるAIアプリケーションの特異性を次のように指摘する。

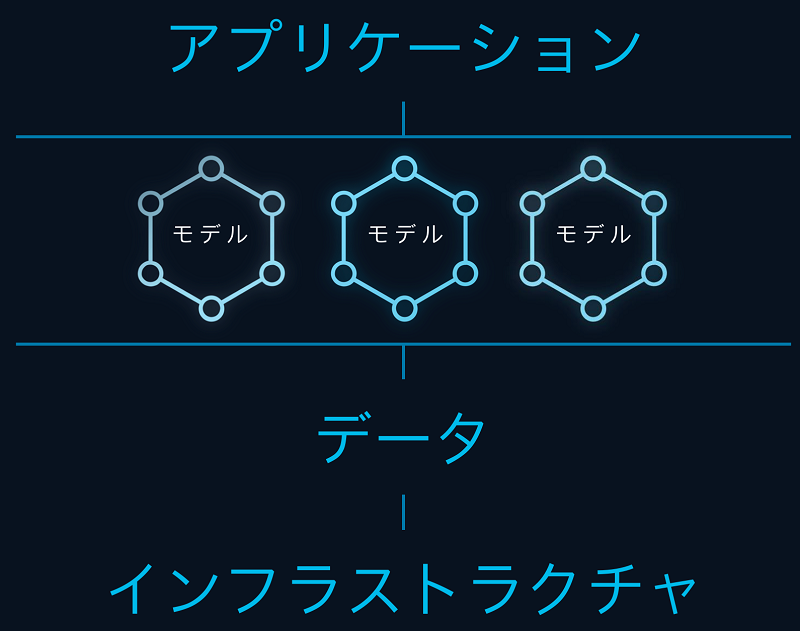

通常のアプリケーションであれば、「インフラストラクチャ」と「データ」があり、その上に「アプリケーション」が載っている形だ。対して、AIアプリケーションでは、新しいレイヤとして「モデル」が挿入されるという特異性だ。

このモデルは、複数の種類が存在する。例えば、ChatGPTは多様な文章を生成できるようにランダム性を取り入れているため、「非決定論的なモデル」となっている。そのため、同じ質問に対し異なる回答となる。だが、Agentic AI時代のAIエージェントが様々な社会インフラで活用されていくと、ランダム性が不要なシーンは多い。一例として、医療診断支援では、LLMが直接自由文を生成するのではなく、事前に定義されたフォーマットや選択肢内で応答するので、非決定論的ではなく、「決定論的なモデル」となる。

探索的判断(柔軟さが求められる)の場合は、 LLMなど非決定論的AIを使用。安全性が重要な判断の場合は、決定論的な手続き・ルールベースを併用。といったように、Agentic AI時代におけるモデルは、多様性やハイブリッド性を強めていくことになる。AIガバナンスのSafetyとSecurityは、この多種多様なモデルの破綻を防ぐことを意味する。

Safetyでは、例えばAIのハルシネーションを抑えるには、SFT(Supervised Fine-Tuning:教師ありファインチューニング)で使われるデータの質とモデルの訓練方法が大きく関係している。これにより、誤情報のリスクを抑えることは、モデルの信頼性に直結する。Sampath氏は「様々なモデルが実際に安全であること、有害ではないことを見極めなければならない」と話す。

一方のSecurityでは、AIセキュリティへの攻撃を防ぐことになる。主な攻撃手法の概要、手法の例、影響、注意すべきAIの種類やシーンは、以下の通り。

プロンプトインジェクション(Prompt Injection)

概要:ユーザが意図しない動作をするように、プロンプトの中に“悪意ある命令”を忍ばせる攻撃。

手法の例:攻撃者の不適切な命令に従うようなプロンプトを埋め込む。

影響:機密情報漏洩、不正な出力、安全対策の回避などが発生してしまう。

注意すべき点:特に、チャットボットやエージェント系AIでは注意が必要な攻撃となる。

データポイズニング(Data Poisoning)

概要:学習データやSFTデータに意図的に誤情報やバイアスを混入させ、モデルの判断を歪める攻撃。

手法の例:ファインチューニング用のデータセットに、偽情報の文脈を混ぜる。

影響:ハルシネーションの誘導、人格攻撃、信頼性の低下が発生してしまう。

注意すべき点:オープンなデータセット利用時や、外部からのデータ収集時に特にリスクが高い。また、ヘルスケア、金融、自動運転車などでは深刻なリスクとなる。

コンテキストオーバーロード(Context Overload)

概要:プロンプトに大量の無関係なテキストを与えて、AIの「注意力」を分散・混乱させる。

手法の例:攻撃者が先に長大な“無害そうな情報”を入れて、肝心のユーザの指示を“埋もれさせる”。

影響:これにより、命令のすり替え、情報の無視、判断の誤誘導が発生してしまう。

注意すべき点:特に、長文のコンテキストウィンドウを活用する大型モデルで効きやすい。

この他にも様々なAIセキュリティへの攻撃手法が存在するので、AI開発者だけでなく、利用者や導入企業にとっても重要な課題となる。Sampath氏は「様々な攻撃手法に対処し、モデルが正常に動くことを担保しなくてはいけない」と話す。

マルチモデル時代のAIガードレール

こうしたSafetyとSecurityの課題がある中、AIの誤動作の防止やセキュリティを担保するための技術的、制度的な安全枠として、各モデルでは「ガードレール」(通信業界に寄せた表現をすると、AIにおけるFW・WAF的な制御)が利用される。だが今後、AIモデルが増えて、利用者がマルチモデル環境でAIを活用するとなると、ガードレールの設計や維持には新たな課題が発生する。

例えば、多種多様な攻撃手法が存在しているため、各モデルはそれぞれ異なる安全ポリシーやSFT方式を持っており、結果として、「拒否する基準が違う」「ガードレールの強さが同一ではない」といったバラつきが生じる。また、各モデルが異なる設計思想・API設計をしていると、ガードレールを横断的に統合管理できないので、セキュリティ部門は全体の安全性が把握しづらい状況となる。

Sampath氏は「全てのモデルを、一つのガードレールでシームレスな形で守っていかなくてはならない。現在のモデルの数は1~5くらいかと思うが、将来は何百ものモデルが登場するだろう。つまり、エンタープライズの中で使われる何百ものモデルを纏めて守っていかなければならないということだ。AIの技術は、これまでは想像もできなかった速度で進化している。かと言って、企業がそれらをスピーディに取り入れるためにSafetyやSecurityを犠牲することはできないので、私達はAIの世界のセキュリティを新しく考え直す必要がある。その答えが、Cisco AI Defenseだ」と話す。

レポート目次

・Agentic AI時代における、SafetyとSecurityの課題